作者

標題 [新聞] Sora到底懂不懂物理世界?一場腦力激盪正

時間 Fri Feb 23 14:05:43 2024

標題 [新聞] Sora到底懂不懂物理世界?一場腦力激盪正

時間 Fri Feb 23 14:05:43 2024

Sora到底懂不懂物理世界? 一場腦力激盪正在AI圈大佬間展開

https://www.linkresearcher.com/information/933841f9-c37c-4e66-91fc-f152567bf3bb

機器之心報道

編輯:張倩、杜偉

Sora 到底是不是實體引擎甚至是世界模型? 圖靈獎得主Yann LeCun、Keras 之父

Francois Chollet 等人正在深入探討。

最近幾天,OpenAI 發布的影片生成模型Sora 成了全世界關注的焦點。

和以往只能產生幾秒鐘影片的模型不同,Sora 把生成影片的長度一下子拉長到60 秒。

而且,它不僅能了解使用者在Prompt 中提出的要求,還能get 到人、物在物理世界中的

存在方式。

而且,它不僅能了解使用者在Prompt 中提出的要求,還能get 到人、物在物理世界中的

存在方式。

以經典的「海盜船在咖啡杯中纏鬥」為例。 為了讓生成效果看起來逼真,Sora 需要克服

以下幾個物理困難:

規模和比例的適應:將海盜船縮小到能夠在咖啡杯中纏鬥的尺寸,同時保持它們的細節和

結構,是一個挑戰。 AI 需要理解和調整這些物件在現實生活中的相對尺寸,使得場景在

視覺上顯得合理;

結構,是一個挑戰。 AI 需要理解和調整這些物件在現實生活中的相對尺寸,使得場景在

視覺上顯得合理;

流體動力學:咖啡杯中的液體會對海盜船的移動產生影響。 AI 模型需要模擬液體動力學

的效果,包括波浪、濺水和船隻移動時液體的流動,這在計算上是複雜的;

光線和陰影的處理:為了讓場景看起來真實,AI 需要精確地模擬光線如何照射在這個小型

場景中,包括咖啡的反光、船隻的陰影,以及可能的透光效果;

動畫和運動的真實性:海盜船的運動需要符合真實世界的物理規律,即使它們被縮小到咖啡

杯中。 這意味著AI 需要考慮到重力、浮力、碰撞以及船體結構在動態環境中的行為。

雖然生成效果還有些瑕疵,但我們能明顯感覺到,Sora 似乎是懂一些「物理」的。 英偉

達高級研究科學家Jim Fan 甚至斷言,「Sora 是一個數據驅動的實體引擎」,「是可學

習的模擬器,或『世界模型』」。

達高級研究科學家Jim Fan 甚至斷言,「Sora 是一個數據驅動的實體引擎」,「是可學

習的模擬器,或『世界模型』」。

部分研究者同意這樣的觀點,但也有不少人反對。

Yann LeCun:產生影片的過程與基於世界模型的因果預測完全不同

圖靈獎得主Yann LeCun 率先亮明觀點。 在他看來,僅僅根據prompt 生成逼真影片並不

能代表一個模型理解了物理世界,生成影片的過程與基於世界模型的因果預測完全不同。

他接著講到,模型生成逼真影片的空間非常大,影片產生系統只需要產生一個合理的範例

就算成功。 不過對於一個真實影片而言,其合理的後續延續空間卻非常小,產生這些延

續的代表性片段,特別是在特定行動條件下,任務難度更大。 此外產生影片的後續內容

不僅成本高昂,實際上也毫無意義。

能代表一個模型理解了物理世界,生成影片的過程與基於世界模型的因果預測完全不同。

他接著講到,模型生成逼真影片的空間非常大,影片產生系統只需要產生一個合理的範例

就算成功。 不過對於一個真實影片而言,其合理的後續延續空間卻非常小,產生這些延

續的代表性片段,特別是在特定行動條件下,任務難度更大。 此外產生影片的後續內容

不僅成本高昂,實際上也毫無意義。

因此,Yann LeCun 認為,更理想的做法是產生影片後續內容的抽象表達,並消除與我們

可能所採取動作無關的場景中的細節。

當然,他藉此又PR 了一波JEPA(Joint Embedding Predictive Architecture,聯合嵌入

預測架構),認為上述做法正是它的核心思想。 JEPA 不是生成式的,而是在表示空間中

進行預測。 與重建像素的生成式架構(如變分自編碼器)、掩碼自編碼器、去噪自編碼

器相比,聯合嵌入架構(如Meta 前幾天推出的AI 視訊模型V-JEPA)可以產生更優秀的視

覺輸入表達。

預測架構),認為上述做法正是它的核心思想。 JEPA 不是生成式的,而是在表示空間中

進行預測。 與重建像素的生成式架構(如變分自編碼器)、掩碼自編碼器、去噪自編碼

器相比,聯合嵌入架構(如Meta 前幾天推出的AI 視訊模型V-JEPA)可以產生更優秀的視

覺輸入表達。

https://twitter.com/ylecun/status/1758740106955952191

François Chollet:只讓AI 看視頻學不成世界模型

Keras 之父François Chollet 則闡述了更細緻的觀點。 他認為,像Sora 這樣的視訊生

成模型確實嵌入了「物理模型」,但問題是:這個物理模型是否準確? 它能否泛化到新

的情況,也就是那些不只是訓練資料插值的情況?

成模型確實嵌入了「物理模型」,但問題是:這個物理模型是否準確? 它能否泛化到新

的情況,也就是那些不只是訓練資料插值的情況?

Chollet 強調,這些問題至關重要,因為它們決定了生成影像的應用範圍—— 僅限於媒

體生產,還是可以用作現實世界的可靠模擬。

Chollet 透過海盜船在咖啡杯中纏鬥的例子,討論了模型能否準確反映水的行為等物理現

象,或者只是創造了一種幻想拼貼。 在這裡,他指出模型目前更傾向於後者,即依賴資

料插值和潛空間拼貼來產生影像,而不是真實的物理模擬。 有人將這種行為類比為人類

做夢,認為Sora 其實只是達到了人類做夢的水平,但是邏輯能力依然不行。

象,或者只是創造了一種幻想拼貼。 在這裡,他指出模型目前更傾向於後者,即依賴資

料插值和潛空間拼貼來產生影像,而不是真實的物理模擬。 有人將這種行為類比為人類

做夢,認為Sora 其實只是達到了人類做夢的水平,但是邏輯能力依然不行。

Chollet 指出,透過機器學習模型擬合大量資料點後形成的高維曲線(大曲線)在預測物

理世界方面是存在局限的。 在特定條件下,大數據驅動的模型能夠有效捕捉並模擬現實

世界的某些複雜動態,例如預測天氣、模擬風洞實驗等。 但這種方法在理解和泛化到新

情況時存在局限性。 模型的預測能力依賴其訓練資料的範圍和質量,對於那些超出訓練

資料分佈的新情況,模型可能無法準確預測。

理世界方面是存在局限的。 在特定條件下,大數據驅動的模型能夠有效捕捉並模擬現實

世界的某些複雜動態,例如預測天氣、模擬風洞實驗等。 但這種方法在理解和泛化到新

情況時存在局限性。 模型的預測能力依賴其訓練資料的範圍和質量,對於那些超出訓練

資料分佈的新情況,模型可能無法準確預測。

所以,Chollet 認為,不能簡單地透過擬合大量資料(如遊戲引擎渲染的影像或影片)來

期望得到一個能夠泛化到現實世界所有可能情況的模型。 這是因為現實世界的複雜性和

多樣性遠遠超過任何模型能夠透過有限數據學習到的。

期望得到一個能夠泛化到現實世界所有可能情況的模型。 這是因為現實世界的複雜性和

多樣性遠遠超過任何模型能夠透過有限數據學習到的。

田淵棟:學習物理需要主動學習或策略強化學習

針對Jim Fan 的觀點,一些研究者提出了更激進的反駁,認為Sora 並不是學到了物理,

只是看起來像是學到了罷了,就像幾年前的煙霧模擬一樣。 也有人覺得,Sora 不過是對

2D 像素的操縱。

只是看起來像是學到了罷了,就像幾年前的煙霧模擬一樣。 也有人覺得,Sora 不過是對

2D 像素的操縱。

https://twitter.com/IntuitMachine/status/1758845715709632873

當然,Jim Fan 對「Sora 沒有在學習物理,而只是操縱2D 像素」這一說法進行了一系列

反駁。 他認為,這種觀點忽略了模型在處理複雜資料時所展現的深層能力。 就像批評

GPT-4 不是學習編碼,只是隨機挑選字串一樣,這種批評沒有認識到Transformer 模型在

處理整數序列(代表文本的token ID)時所表現出的複雜理解和生成能力。

https://twitter.com/DrJimFan/status/1758549500585808071

對此,Google研究科學家Kevin P Murphy 表示,他不確定最大化像素的可能性是否足以

促使模型可靠地學到精確的物理,而不是看似合理的動態視覺紋理呢? 是否需要MDL(

Minimum description length,最小描述長度)呢?

促使模型可靠地學到精確的物理,而不是看似合理的動態視覺紋理呢? 是否需要MDL(

Minimum description length,最小描述長度)呢?

https://twitter.com/sirbayes/status/1759101992516112864

同時,知名AI 學者、Meta AI 研究科學家田淵棟也認為,關於Sora 是否有潛力學到精確

的物理學(當然現在還沒有),背後的關鍵問題是:為什麼像「預測下一個token」或“

重建」這樣簡單的思路會產生如此豐富的表示法?

的物理學(當然現在還沒有),背後的關鍵問題是:為什麼像「預測下一個token」或“

重建」這樣簡單的思路會產生如此豐富的表示法?

他表示,損失函數如何被激發的並不重要,損失函數的設計動機(無論多麼哲學化或複雜

)並不直接決定模型能否學到更好的表示。 事實上,複雜的損失函數可能與看起來很簡

單的損失函數實際上產生了類似的效果。

)並不直接決定模型能否學到更好的表示。 事實上,複雜的損失函數可能與看起來很簡

單的損失函數實際上產生了類似的效果。

最後他稱,為了更好地理解事物,我們確實需要揭開Transformers 的黑盒子,檢查給定

反向傳播的訓練動態,以及如何學習隱藏的特徵結構,並探索如何進一步改進學習過程

。

反向傳播的訓練動態,以及如何學習隱藏的特徵結構,並探索如何進一步改進學習過程

。

https://twitter.com/tydsh/status/1759293967420805473

田淵棟也表示,如果想要學習精確的物理,他敢打賭需要主動學習或策略強化學習(無論

如何稱呼它)來探索物理的精細結構(例如物體之間的相互作用、硬接觸)。

https://twitter.com/tydsh/status/1759389064648888395

其他觀點:Sora 被認為是「數據驅動的實體引擎」太荒謬

除了眾多AI 圈大佬之外,也有一些專業性的觀點開始反駁Sora 懂物理引擎這個說法。

例如下面這位推特部落客,他認為OpenAI 是數據驅動的物理引擎這一觀點是荒謬愚蠢的

, 就好像收集了行星運動的數據並將它們餵給一個預測行星位置的模型,然後就得出此

模型內部實現了廣義相對論的結論。

例如下面這位推特部落客,他認為OpenAI 是數據驅動的物理引擎這一觀點是荒謬愚蠢的

, 就好像收集了行星運動的數據並將它們餵給一個預測行星位置的模型,然後就得出此

模型內部實現了廣義相對論的結論。

https://twitter.com/ChombaBupe/status/1759226186075390033

他稱,愛因斯坦花了很多年時間才推導出了重力理論的方程式。 如果有人認為隨機梯度

下降(SGD)+ 反向傳播僅憑輸入輸出對就能理解一切,並在模型訓練中解決問題,那麼

這個人對於機器學習的理解是有問題的,對機器學習的工作方式了解也不夠。

下降(SGD)+ 反向傳播僅憑輸入輸出對就能理解一切,並在模型訓練中解決問題,那麼

這個人對於機器學習的理解是有問題的,對機器學習的工作方式了解也不夠。

愛因斯坦在理論推導中對現實做出了許多假設,例如光速恆定、時空是靈活的結構,然後

推導出了微分方程,其解揭示了黑洞、重力波等重大發現。 可以說,愛因斯坦利用因果

推理將不同的概念連結了起來。

推導出了微分方程,其解揭示了黑洞、重力波等重大發現。 可以說,愛因斯坦利用因果

推理將不同的概念連結了起來。

但是,SGD + 反向傳播並不是這樣,它們只是將資訊壓縮到模型權重中,並不會進行推理

,只是更新並轉向實現具有最低誤差的參數配置。

他認為,機器學習(ML)中的統計學習過程可能會顯然低誤差“盆地”,即無法探索不同

的概念, 因為一旦陷入這些低誤差“盆地”或局部最小值就無法重新開始。

因此,SGD + 反向傳播發現了看似有效但卻很容易崩潰的、脆弱的解決方案捷徑。 這就

是為什麼深度學習系統不可靠且實際訓練起來很難,你必須在現實中不斷更新和訓練它們

,這就很麻煩。

是為什麼深度學習系統不可靠且實際訓練起來很難,你必須在現實中不斷更新和訓練它們

,這就很麻煩。

梯度下降的工作原理就像一隻蒼蠅尋找氣味源一樣,即蒼蠅跟隨空氣中的化學濃度向下移

動,從而引導它導向氣味源。 但如果僅依賴這種方式,就很容易迷路或陷入困境。

在機器學習中,模型的可調式參數就像蒼蠅,訓練資料就像氣味源,目標函數測量的誤差

就像氣味。 而調整模型權重的目的是朝著氣味源(這裡是低誤差,相當於更濃的氣味)

移動。

就像氣味。 而調整模型權重的目的是朝著氣味源(這裡是低誤差,相當於更濃的氣味)

移動。

最後,他得出結論,如果認為機器學習模型僅僅透過訓練行星運動的影片就能在內部學到

廣義相對論,那就更荒謬了。 這是對機器學習原理的嚴重誤解。

此外,有網友指出Sora 影片範例充滿了物理錯誤,例如一群小狗在雪中玩鬧的場景就很

糟糕,大塊雪的運動就完全違反了重力(是否真如此,有待判斷)。

https://twitter.com/MikeRiverso/status/1759271107373219888

Sora 到底懂不懂物理? 將來會不會懂? 「預測下一個token」是不是通往AGI 的一個方

向? 我們期待各路研究者進行進一步驗證。

--

※ 發信站: 批踢踢實業坊(ptt.cc), 來自: 123.192.157.241 (臺灣)

※ 作者: jackliao1990 2024-02-23 14:05:43

※ 文章代碼(AID): #1bs3Mxiw (Tech_Job)

※ 文章網址: https://www.ptt.cc/bbs/Tech_Job/M.1708668347.A.B3A.html

※ 編輯: jackliao1990 (123.192.157.241 臺灣), 02/23/2024 14:06:07

--

→ : 直接講結論 當然不懂

把lecun的解釋看看就懂了

世界模型不可能以這種方式建構1F 02/23 14:24

把lecun的解釋看看就懂了

世界模型不可能以這種方式建構1F 02/23 14:24

推 : 要是哪天真的暴力破解 一堆遊戲3d engine的公司就丸子4F 02/23 14:27

→ : 蒼井空是世界的6F 02/23 14:31

推 : 如果真的可以train出一個懂物理模型的model是不是代表了他的loss function 就隱含了夠正確的物理模型?7F 02/23 14:50

推 : 首先你要先定義甚麼是懂物理模型的model

人類對物理世界的了解連1%都不到 你要怎麼參照?10F 02/23 14:53

人類對物理世界的了解連1%都不到 你要怎麼參照?10F 02/23 14:53

推 : 拿來做動畫不懂也沒差12F 02/23 14:54

推 : 人類都不懂世界了,期待人類訓練的AI懂?13F 02/23 14:54

推 : 人類物理學家終將滅亡14F 02/23 15:23

推 : 原理還是看SIGGRAPH的論文比較有啟發15F 02/23 15:36

→ : 現在一定還不懂 但遲早的事

應該還是現在的物理引擎產生各種訓練資料(AI輔助)然後再用這些資料拿去訓練16F 02/23 15:46

應該還是現在的物理引擎產生各種訓練資料(AI輔助)然後再用這些資料拿去訓練16F 02/23 15:46

→ : 他都能當你物理老師了還不董物理嗎19F 02/23 16:06

→ : 沒學過物理的人可以畫出其他人看起來合理的湖水20F 02/23 16:23

→ : 要先定義什麼是懂,現在的神經網路有人有中文房間問題,像樓上的LLM給出物理教學,究竟只是這些權重預測這個prompt和先前的token應該放出下一個token機率最高的恰巧會讓人類以為他懂物理,還是他真的懂物理從預測失敗的例子大概就知道他根本什麼都不懂,只是近期可能的模仿人類而已

其實這類AI本質上跟芙莉蓮的魔族(人形的魔物)一樣,本身不是人類也不在乎要不要用人類的方式去弄懂世界,只是像鸚鵡一樣知道講某些話會有讓人類以為他們懂的效果而已

跟之前對LLM暈船的研究員一樣,模型只是在吐出你想聽的話而已,如果你覺得他有意識那他就會吐會讓你覺得他有意識的output

他並不需要真的有意識,只要讓你認為他有意識就能讓你設定的loss function happy了

這類模型就是盡其所能的唬爛,講錯的時候唬得跟真的一樣

但其實講對的時候對模型而言它何嘗不也只是在唬爛?它根本不知道自己講的對不對,只知道生這些token可以有最大的機會降低loss而已

Sora本身的架構也是LLM,以預測像素token為核心,一樣會和現行LLM有短期context乍看之下正常,長期context狗屁不通的問題21F 02/23 16:27

其實這類AI本質上跟芙莉蓮的魔族(人形的魔物)一樣,本身不是人類也不在乎要不要用人類的方式去弄懂世界,只是像鸚鵡一樣知道講某些話會有讓人類以為他們懂的效果而已

跟之前對LLM暈船的研究員一樣,模型只是在吐出你想聽的話而已,如果你覺得他有意識那他就會吐會讓你覺得他有意識的output

他並不需要真的有意識,只要讓你認為他有意識就能讓你設定的loss function happy了

這類模型就是盡其所能的唬爛,講錯的時候唬得跟真的一樣

但其實講對的時候對模型而言它何嘗不也只是在唬爛?它根本不知道自己講的對不對,只知道生這些token可以有最大的機會降低loss而已

Sora本身的架構也是LLM,以預測像素token為核心,一樣會和現行LLM有短期context乍看之下正常,長期context狗屁不通的問題21F 02/23 16:27

推 : soma來了44F 02/23 16:46

→ : 期望ai能比人類更快發現新的自然方程式45F 02/23 16:50

噓 : 推文真的是笑死人,不懂裝得很厲害喔。Sora是Diffusion Transformer 模型,,不是LLM。

更簡單說法:diffusion model,1不是LLM。46F 02/23 17:30

更簡單說法:diffusion model,1不是LLM。46F 02/23 17:30

推 : 七年前 GAN 模型已可生成圖片

Sora 則是整合 Open AI LLM 去處理 text 的部分

DM 又比 GAN 效果更好

要看起來違反物理, 可以是水往上流(視覺錯覺)

也可以是虹吸管原理

從來都不需要在一部影片裡構築完整的物理世界

就跟漫威宇宙電影不會全部塞在同一集一樣49F 02/23 17:37

Sora 則是整合 Open AI LLM 去處理 text 的部分

DM 又比 GAN 效果更好

要看起來違反物理, 可以是水往上流(視覺錯覺)

也可以是虹吸管原理

從來都不需要在一部影片裡構築完整的物理世界

就跟漫威宇宙電影不會全部塞在同一集一樣49F 02/23 17:37

→ : 不用懂只要超越現在那些現有的即可

不管他用什麼方式只要能超越現有的就是優點

講白了這點就是讓你們失業的主因

他已經超越你工作的極限!56F 02/23 18:05

不管他用什麼方式只要能超越現有的就是優點

講白了這點就是讓你們失業的主因

他已經超越你工作的極限!56F 02/23 18:05

推 : 其實怎麼想都覺得一定很快 舉個例unreal engine 生成的東西拿去training 學會物理特性以後再diffusion 就好惹60F 02/23 18:08

→ : 物理不就是數學 ai強多了63F 02/23 18:24

→ : 推文好多頂級researcher,這波台灣AI就靠大大們了64F 02/23 18:35

推 : 我要看到血流成河65F 02/23 19:45

→ : 置板凳66F 02/23 20:02

推 : 現在的訓練方式模型當然是不懂的,我認為比較可以理解成‘‘考古題有教這樣寫所以我跟著寫’’,不是‘

‘我理解物理原理所以我這樣解題’’。67F 02/23 20:24

‘我理解物理原理所以我這樣解題’’。67F 02/23 20:24

噓 : 結論All in NVDA SMCI70F 02/23 21:04

噓 : 說「懂」就太裝B了 ai大概就是跟狗狗握手一樣有基礎因果判斷能力吧 人與人都無法判斷對方懂不懂 哪有可能判斷ai懂不懂 搞笑喔71F 02/23 21:08

→ : 蟻王跟尼特羅 PK, 蟻王窮舉法贏了尼特羅

但尼特羅說蟻王不懂人類74F 02/23 21:16

但尼特羅說蟻王不懂人類74F 02/23 21:16

推 : 樓上你看哪部的蟻王有用窮舉法76F 02/23 21:31

推 : 一堆工程師考試上碩班,Fourier transform 跟Maxwell equation 真的要解釋含義是多少人懂?

AI寫得出好的答案不代表真的懂77F 02/23 21:32

AI寫得出好的答案不代表真的懂77F 02/23 21:32

推 : 嗯嗯 跟我想的差不多80F 02/23 22:20

推 : 看到流體力學造動畫我就end了81F 02/23 22:21

推 : AI還少了理解這個世界的動力或是慾望82F 02/24 00:07

推 : 人人都能編造電影給觀看83F 02/24 00:14

→ : Ai人云亦云會變笨啊

Loss function把已知的物理公式都帶進去看看84F 02/24 00:40

Loss function把已知的物理公式都帶進去看看84F 02/24 00:40

→ : 某半桶水又在亂講AI了 顆顆 Alignment是通往了解

世界模型方法 所以LLM的Reasoning變很重要

透過alingment text和影像latent space才能結合

所以Lecunn才會認為embeding(alignment)是拆解因果演言之啦diffusion會無腦產生影像 你需要用reasonin去控制它產生方式 所以LLM才能引導diffusion

https://arxiv.org/abs/2305.13655

所以說sora會跟LLM有相關 在我們這行不能算錯

Dall-E 3+ChatGPT就是這樣用法

你去看dalle架構是透過CLIP (Text-Img Alginment)當然你也可以手動給text去guide diffusion來取代LLM每張每張的去產生影片 只是這樣太花時間86F 02/24 00:54

世界模型方法 所以LLM的Reasoning變很重要

透過alingment text和影像latent space才能結合

所以Lecunn才會認為embeding(alignment)是拆解因果演言之啦diffusion會無腦產生影像 你需要用reasonin去控制它產生方式 所以LLM才能引導diffusion

https://arxiv.org/abs/2305.13655

所以說sora會跟LLM有相關 在我們這行不能算錯

Dall-E 3+ChatGPT就是這樣用法

你去看dalle架構是透過CLIP (Text-Img Alginment)當然你也可以手動給text去guide diffusion來取代LLM每張每張的去產生影片 只是這樣太花時間86F 02/24 00:54

[2305.13655] LLM-grounded Diffusion: Enhancing Prompt Understanding of Text-to-Image Diffusion Models with Large Language Models Recent advancements in text-to-image diffusion models have yielded impressive results in generating realistic and diverse images. However, these model ...

推 : 如果學得到精確的物理關係,拿去做機器人會比作影片來得有價值吧98F 02/24 01:06

→ : 樓上 所以現在大家都在追求世界模型解法啊

現在有些reasoningLLM和CLIP拿去做在機器人上

所以造就了LLMAgent這個方向100F 02/24 01:08

現在有些reasoningLLM和CLIP拿去做在機器人上

所以造就了LLMAgent這個方向100F 02/24 01:08

推 : 先說結論,目前Navier-Stokes流體是無解的,甚至我們用AI也只是玩個皮毛罷了!103F 02/24 01:51

→ : 我好像看得懂他們在說什麼 慘了

真不應該,這不是我現在應該要會的105F 02/24 03:48

真不應該,這不是我現在應該要會的105F 02/24 03:48

推 : 就娛樂來講,夠用了啦107F 02/24 04:51

噓 : 時間, 才推出多久?108F 02/24 09:50

→ : 現在問題可能會是未來ai是98%人類知識的頂端!你必須不斷證明自己的知識是有巨大價值的不然就無法得到2%人類知識探索的資格!未來只要是ai能回答的問題基本上大家認知水平都差不多!即便他跟本不理解也可以用ai代替!你們正把世界變成這樣!109F 02/24 09:52

推 : 讓sora破幾次薩爾達應該就學得會了114F 02/24 11:49

推 : 如果可行以後科學理論說不定都用巨量資料跟算力來解115F 02/24 12:49

推 : 結論 歐印AI116F 02/24 16:25

噓 : 一堆人在那邊講幾%幾%,看得我好躁117F 02/24 20:17

→ : 很多人還沒有搞清楚狀況!當你失去獨立思考的能力時,你就很容易回到封建時代!你認為很正常合理的事情其實只是你的認知被侷限在缺乏突破性思考的框架裡!講個淺顯易懂的就是什麼公司掛上了科技兩個字不論他技術含量有多少看起來都好像很厲害,什麼科系前面都要掛一個科學看起來好像很厲害,什麼人頭銜掛個工程師看起來好像很厲害!很多事情當你不具備相關領域的專業時是不容易跨出那個框架!118F 02/24 20:26

--

作者 jackliao1990 的最新發文:

- 美國在德國部署約百枚核彈 然而德國新總理弗里德里希·梅爾茨卻認為 我們必須習慣川普將不再完全履行北約條約的援助條款的想法 德國需要與英法討論核共享 "至少是英國和法國的核安全可以也適用於我們 …127F 57推 8噓

愛沙尼亞前總理 歐盟執委會副主席兼歐盟外交與安全政策高級代表 卡雅·卡拉斯表示: "我們將加大對烏克蘭的支持,以便他們能夠繼續反擊侵略者。 今天,自由世界需要一位新的領導人,這一點已變得十分 …153F 67推 7噓

愛沙尼亞前總理 歐盟執委會副主席兼歐盟外交與安全政策高級代表 卡雅·卡拉斯表示: "我們將加大對烏克蘭的支持,以便他們能夠繼續反擊侵略者。 今天,自由世界需要一位新的領導人,這一點已變得十分 …153F 67推 7噓 棒球世界盃 歐洲杯 歐冠抽籤儀式 除了會請知名退役球星也會請藝人 每次都很刺激 收視率高又能炒熱氣氛 棒球經典賽如果跟進 請退役球星如鈴木一朗 佩卓 等人來抽籤 請韓女團當司儀 看看哪國會抽到死亡之 …272F 114推 8噓

棒球世界盃 歐洲杯 歐冠抽籤儀式 除了會請知名退役球星也會請藝人 每次都很刺激 收視率高又能炒熱氣氛 棒球經典賽如果跟進 請退役球星如鈴木一朗 佩卓 等人來抽籤 請韓女團當司儀 看看哪國會抽到死亡之 …272F 114推 8噓 2月12日法國原子能與替代能源委員會(CEA)的托卡馬克裝置WEST 通過2兆瓦的功率保持穩定 將電漿態穩定維持了1337秒 成為新的世界紀錄 支那東方超環(EAST)1月20日的1066秒紀錄只維 …117F 67推 11噓

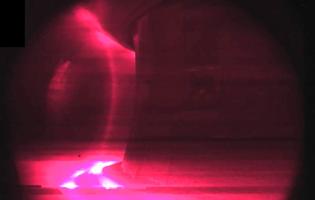

2月12日法國原子能與替代能源委員會(CEA)的托卡馬克裝置WEST 通過2兆瓦的功率保持穩定 將電漿態穩定維持了1337秒 成為新的世界紀錄 支那東方超環(EAST)1月20日的1066秒紀錄只維 …117F 67推 11噓

點此顯示更多發文記錄