※ 本文轉寄自 ptt.cc 更新時間: 2025-01-30 20:45:37

看板 Stock

作者 標題 Re: [新聞] OpenAI:已掌握DeepSeek盜用模型證據

時間 Thu Jan 30 07:26:03 2025

以下部分資訊來自於Reddit anitakirkovska文章的翻譯

LDPC哥哥講到一個重點

Reinforcement Learning =/= Reinforcement Learning from Human Feedback

這也是R1為什麼爆紅的原因

https://imgur.com/lunsvb2.jpg

![[圖]](https://imgur.disp.cc/43/lunsvb2.jpg)

GPT-4最強的地方是他有了某方面的"思考鍊"

(chain-of-thought) 也就是能做出更靈活更準確的推理

但OpenAI是怎麼做出來的並沒有公開,而Deepseek R1是直接公布出來

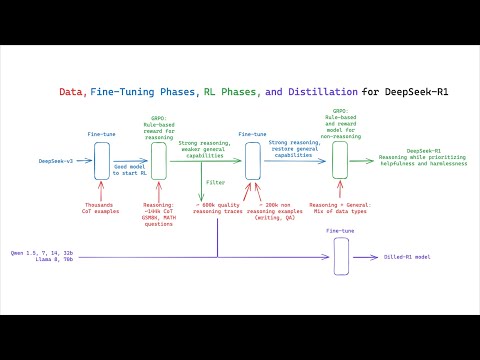

圖裡面的縮寫全名如下

Cold start data: 最低限度標記的資料集合,讓模型更好理解任務

RL: Reinforcement Learning 模型透過評分獎勵來學習正確答案以及思考邏輯

RLHF = 用人工審查,所以才有當初Google要員工去餵Bard的新聞

SFT: Supervised fine-tuning 用標記的資料去訓練模型讓他在特定領域中更精準

Rejection sampling: 模型產出多個結果的時候選擇特定滿足標準的輸出

其實其他部分都差不多,但Deepseek是用什麼方式去壓低成本去做Pure RL?

用他們自己研發的Gpro (Group Robust Preference Optimization)

https://arxiv.org/abs/2405.20304

[2405.20304] Group Robust Preference Optimization in Reward-free RLHF Abstract page for arXiv paper 2405.20304: Group Robust Preference Optimization in Reward-free RLHF ...

他們怎麼不透過人工去確定產出優劣?

邏輯就是建立最佳猜測的模型: Coherence, Completeness, Fluency

但這也帶來另外一個缺點

就是poor readability (閱讀性差)、language mixing(語言混和)

所以Deepseek用第一張圖的方式去解決

Cold start data處理易讀性

用RL+Rejection sampling+SFT反覆驗證計算並Fine tune 結果

但R1背後的意涵,其實是RL能讓小模型在專精領域出頭天

透過Distill然後微調RL內容,可以在專精領域如藥物、材料...等取得更好的成果

而不用再被綁死於大型語言service provider的服務

而這個也帶來一個影響

企業在AI應用上會更有彈性,同時AI實際應用的穿透性更高

https://tinyurl.com/ms2vev4s

AI research team claims to reproduce DeepSeek core technologies for $30 — relatively small R1-Zero model has remarkable problem-solving abilities | Tom's Hardware

![[圖]]() PhD-candidate Jiayi Pan led a team at UC Berkeley that reproduced the core technology of DeepSeek R1-Zero for just $30, showing how AI could become af ...

PhD-candidate Jiayi Pan led a team at UC Berkeley that reproduced the core technology of DeepSeek R1-Zero for just $30, showing how AI could become af ...

![[圖]](https://cdn.mos.cms.futurecdn.net/zfDV4Yc5qbdYxR9jC8U8NA-1200-80.jpg)

R1背後的邏輯和技術,用在小模型上面有極大的成本優勢

大型語言的發展依然會持續,但硬體算力軍備競賽的資本投入勢必會減少

因為大型語言還是適合多數小白使用者 (如我)

以GPT-4來說,他給的回答訊息會很完整包括前因後果

而R1給的就是非常簡潔.....不太廢話

對專業人士來說,R1有時候只給你一行字其實非常的有效率

但智障如我就必須要花更多時間去思考

BTW R1在Ethical Considerations 上面多數人評價是比GPT4還好喔XDDDD

看到這東西,反正是開源的,程式碼都攤開在那邊給你看

應該是要想著怎麼去利用,而不是討論中/美或成最大贏家嗎?

怎麼搞到變成政治意識形態的爭執了?

有些推文一直扯到超導體,我就不懂有什麼可比性...

本身有一點點計算機概論底子加上英文能力就可以去稍微理解這東西

結果很多人都只用台灣媒體或網紅的貼文去判斷,這個邏輯不太行阿

※ 引述《LDPC (Channel Coding)》之銘言:

: 現在全網路上的開源數據資料是屬於pre-training端 大多都是野生數據 無標籤

: 那東西只是讓模型去向鸚鵡一樣 去做文字接龍

: 但第二階段訓練會用到RLHF (Reinforcement Learning from Human Feedback)

: 就是要人類針對不同數據給意見 這個是要給標籤

: 所以你才會聽到狗家之前要求全公司員工去給意見讓Gemini前身 Bard 去做人類feedback

: 這個人工成本是很大

: Deepseek-R1跟大家說 我們不用人類給的feedback了 我們可以免除這塊

: 大家都在討論的叫做sythetic dataset

: 這個步驟是來自於你有許多野生數據 但需要加上標籤 那標籤可以拿更強大模型來標註

: 比方說 一道數學題目 你可以用人類寫解答 或者要拆步驟 每步驟讓gpt-4o寫個答案

: 這就是所謂synthetic dataset 然後用這組數據去調教模型 這步驟會決定

: 你的模型多智能 這過程就是call api 現在ai界都這樣幹 缺點就是訓練模型上限就是

: 原始母模型 這跟傳統蒸留 用模型直接交模型不太依一樣

: 這種方式就是可以用低成本 接近gpt-4o 但你如果這樣幹 你模型就不能商業化

: 頂多發表到文章 講你這是怎樣做 最經典例子就是LLaVA那篇 講如何用gpt4o

: 產生sythetic dataset讓textLLM 變成多模態 直接打爆其他大廠高成本多模態

: 之前網路上已經有人在討論 到底deepseek有沒有用api去合成數據

: https://reurl.cc/A6ab98

: https://x.com/bboczeng/status/1883374489519698413 (zero是r1第一版)

: 在training這部分還沒定案之前 大家就先吃瓜看看吧 @@

: 但這思路還是有可取之處 就是模型教模型 不要再用人類RLHF去教模型

: https://x.com/op7418/status/1884065603184681162

: 這有點像回到當年alphago那條路線 模型互相教

: 下面網址是第三方 大家要複製deep-seek R1開源計畫 任何人想參加都可以

: https://huggingface.co/blog/open-r1

: 目前公認是dep-seek R1隱藏了

: Replicate the R1-Distill models by distilling a high-quality

: reasoning dataset from DeepSeek-R1.

: 上面專案在徵求大家嘗試去製造出合成數據

: 好了 我要去炸薯條了 @@/ 救救我

: ※ 引述《IBIZA (溫一壺月光作酒)》之銘言:

: : 各家互相參考, 指的是訓練方法還有訓練的文本挑選, 蒸餾不太一樣

: : AI = 模型的程式碼+訓練

: : 能開源的部分只有程式碼, 訓練是看各自調教

: : 模型的能力夠, 差不多的調教方式就會得到差不多的結果

: : 訓練方法更好, 或是文本品質越高、越多樣、量越多, 模型就越強

: : 自從OpenAI爆紅以來, 大公司的LLM模型都是遵循OpenAI的訓練方法

: : 預先訓練: 拿大量文本讓AI模型學習基本語言能力、基本知識

: : 監督微調: 有了基本能力之後, 模型開始有推理能力

: : 這時候由人類介入, 告訴模型怎麼想是對的, 怎麼想是錯的

: : 之前所謂的貼標籤, 就是這個階段

: : 獎勵建模: 把對錯的判斷建立模型, AI想對了, 這個模型就獎勵他

: : 強化學習: AI自己跟自己練習

: : 不管是meta還是google, 之前都是照OpenAI這個成功模式做

: : 所以這些公司能做的就是拚算力, 透過更大量的訓練, 希望最終可以暴力超車

: : 但蒸餾就不同, 蒸餾是直接拿另一個模型的推理結果, 讓另一個模型照著得到同樣結果

: : 譬如我要我剛剛問ChatGPT, 要他給舉例說明什麼是擬人法

: : 他的回答是這樣

: : https://i.imgur.com/ey5mX61.png

: : ChatGPT要回答這個問題, 中間要經過很多推理, 譬如他要先理解我的問題

: : 這裡面就牽涉到, 他要理解我講的擬人法是修辭當中的擬人法

: : 然後再從這一個理解, 去思考擬人法的意思是甚麼, 最後再想出一個符合範例

: : 蒸餾的話, 就是學生模型已經預先知道這個問題的答案是甚麼

: : 有頭有尾, 要生出中間的推理就會比較容易

: : 但這裡有個問題

: : 你要用蒸餾讓一個模型得到另一個模型類似的能力

: : 通常就是需要老師模型產生極大量的練習後結果

: : 才能傳授畢生功力給學生模型

: : 如果ChatGPT是開源模型, 可以自己部署在自己平台上

: : 要做這樣大規模訓練是有可能

: : 但ChatGPT無法部署在自己平台

: : (剛剛有人說ChatGPT 2可以, 但蒸餾頂多只能逼近老師, 用ChatGPT 2只能蒸出垃圾)

: : 所以要做蒸餾只能透過API, 而要透過API做幾千萬甚至幾億規模的蒸餾訓練

: : 這難度極高啊....

: : (ChatGPT剛剛教我另一個方法

: : 就是拿一個原本就有ChatGPT4能力的模型

: : 這樣只要少量訓練, 就能超越ChatGPT 4

: : 但原本就有ChatGPT 4能力的新模型難道自己會生出來嗎XD

: : 你還是得先得到這個模型啊...就是V3

: : 那V3怎麼來?)

--

※ 發信站: 批踢踢實業坊(ptt.cc), 來自: 1.163.78.138 (臺灣)

※ 作者: zzahoward 2025-01-30 07:26:03

※ 文章代碼(AID): #1dchaFQv (Stock)

※ 文章網址: https://www.ptt.cc/bbs/Stock/M.1738193167.A.6B9.html

※ 同主題文章:

01-29 21:37 ■ [新聞] OpenAI:已掌握DeepSeek盜用模型證據

01-29 21:38 ■ Re: [新聞] OpenAI:已掌握DeepSeek盜用模型證據

01-29 22:38 ■ Re: [新聞] OpenAI:已掌握DeepSeek盜用模型證據

01-29 23:20 ■ Re: [新聞] OpenAI:已掌握DeepSeek盜用模型證據

01-30 02:44 ■ Re: [新聞] OpenAI:已掌握DeepSeek盜用模型證據

● 01-30 07:26 ■ Re: [新聞] OpenAI:已掌握DeepSeek盜用模型證據

01-30 08:59 ■ Re: [新聞] OpenAI:已掌握DeepSeek盜用模型證據

推 : 消息一堆,但我只相信真金白銀交易的投資人,看這三1F 01/30 07:35

→ : 天NV, tsmc adr 股價就知道了

→ : 天NV, tsmc adr 股價就知道了

推 : 青鳥:DS有沒有台灣價值,沒有就是垃圾3F 01/30 07:46

![[圖]](https://i.imgur.com/2TppMS1h.png)

推 : 少年股神:崩盤時就是世界末日5F 01/30 07:48

→ : 小模型套完是真的會變強的6F 01/30 07:48

推 : 開盤會跌多少7F 01/30 07:49

推 : 推 結論8F 01/30 07:50

→ : 台灣人素質比美國人爛多了9F 01/30 07:51

→ : reddit一堆專業文

→ : 台灣人只會在那邊64

→ : 笑死

→ : 還什麼破解言論審查 的it大臣也能上新聞lol

→ : reddit一堆專業文

→ : 台灣人只會在那邊64

→ : 笑死

→ : 還什麼破解言論審查 的it大臣也能上新聞lol

推 : 驗證台灣媒體這次一半以上都是垃圾14F 01/30 07:53

→ : 各國的論壇看一看15F 01/30 07:53

→ : 台灣論壇素質跟回教國家差不多

→ : 台灣論壇素質跟回教國家差不多

而且我本身也沒完整的專業知識,所以也只能Distill? XD

但整串看下來,有些人連distill都不會.....

→ : 回教社會 隨便一個文章都能扯到 宗教對抗19F 01/30 07:54

→ : 台灣是隨便一個文章都能扯到抗中保台

→ : 北七

→ : 台灣是隨便一個文章都能扯到抗中保台

→ : 北七

GitHub - huggingface/open-r1: Fully open reproduction of DeepSeek-R1

![[圖]]() Fully open reproduction of DeepSeek-R1. Contribute to huggingface/open-r1 development by creating an account on GitHub. ...

Fully open reproduction of DeepSeek-R1. Contribute to huggingface/open-r1 development by creating an account on GitHub. ...

推 : 這篇算完整,但股版講這麼細喔,我前幾篇都沒講想24F 01/30 07:55

→ : 說真的有人會想看嗎

→ : 說真的有人會想看嗎

→ : DS 的技術當然是真的,對開發LLM和推理模型也很有26F 01/30 07:56

→ : 幫助,但也確實蠻有可能在中間用到ChatGPT 的生成去

→ : 幫助,但也確實蠻有可能在中間用到ChatGPT 的生成去

→ : 台灣是說你五毛粉紅支那28F 01/30 07:56

→ : 回教是說 你真主阿拉的叛徒

→ : 笑死

→ : 回教是說 你真主阿拉的叛徒

→ : 笑死

→ : 微調,美中如何出手和股市息息相關 誰說不重要,這31F 01/30 07:56

→ : 是股板

→ : 是股板

推 : 大的搞的了小的,小的搞不了大的,有沒有可能以後一33F 01/30 07:57

→ : 個星門就可以解決所有問題?

→ : 個星門就可以解決所有問題?

推 : 看了一下gpro原來是ppo的變化型 本來需要一個等同36F 01/30 07:59

→ : 模型規格的actor變成分組驗證 在網路上一直搜尋新

→ : 的輸出讓RL準確性更高

→ : 模型規格的actor變成分組驗證 在網路上一直搜尋新

→ : 的輸出讓RL準確性更高

推 : 台灣就是文組誤國啊 理組負責賺錢給文組亂花39F 01/30 08:00

→ : 上面文章分析很好,兩者間不影響繼續資本支出40F 01/30 08:01

推 : 推這篇41F 01/30 08:01

推 : 高佳魚學姊委員就是猛打中國造假 還上YAHOO頭版42F 01/30 08:02

推 : 推43F 01/30 08:06

推 : 這邊就是低能網軍互打,期待啥素質44F 01/30 08:07

推 : 經過這次事件才知道台灣很多人很有勇氣 愛搶著出來45F 01/30 08:09

→ : 發文讓大家知道自己沒長腦

→ : 發文讓大家知道自己沒長腦

→ : 正常台灣人連假都在日本玩,不然就是計畫出國,在47F 01/30 08:09

→ : 這邊鬼混帶風向要嘛5毛要嘛1450

→ : 這邊鬼混帶風向要嘛5毛要嘛1450

推 : 嗯嗯跟我想的差不多(?49F 01/30 08:10

推 : 推50F 01/30 08:11

推 : 討論到這答案大概也揭曉了 gpro是關鍵 但是跟RLHF51F 01/30 08:11

→ : 相比 大概只有數理這種答案對錯很明確的問題吃香

→ : 玩agi不小心玩出edge的未來趨勢?哈

→ : 相比 大概只有數理這種答案對錯很明確的問題吃香

→ : 玩agi不小心玩出edge的未來趨勢?哈

→ : 沒發現多數心得只有兩種嗎。5毛:中國超強。1450:54F 01/30 08:12

→ : 中國製不可信

→ : 中國製不可信

推 : 標準 股板 無用文56F 01/30 08:13

→ : 看台灣的評論 會覺得DS是假貨 一堆假專家57F 01/30 08:14

推 : 推,做股票還在意識形態根本就找死而已,當然是看58F 01/30 08:18

→ : 哪邊有利就壓哪邊

→ : 哪邊有利就壓哪邊

→ : distillation不是微調啊,會有爭議的是他拿別人的大60F 01/30 08:19

→ : 模型來當他自己的訓練

→ : MoE也不是新概念,其實OpenAI和Gemini裡面都是

其實很多小模型都用別人的模型來訓練阿 然後Distillation應該是指V3的部分?→ : 模型來當他自己的訓練

→ : MoE也不是新概念,其實OpenAI和Gemini裡面都是

但V3本身是"Nothing",R1對V3的演算法才是重點

V3水準一堆開源都做得到

推 : 樓上沒看解說齁?r1是蒸餾自己的model欸63F 01/30 08:21

→ : 結論是他們很有效率的用其他人的模型為輔助產生了新64F 01/30 08:22

→ : 的模型,這對於很多新進廠商很有幫助

→ : 的模型,這對於很多新進廠商很有幫助

推 : 不懂又愛鬼扯太多,跟舊版chatgpt一個德行66F 01/30 08:23

→ : 誰跟你說他只有蒸餾自己的model?67F 01/30 08:23

推 : 推68F 01/30 08:24

推 : 看不懂的跟我去洗碗就好惹69F 01/30 08:25

→ : 應該說很多不太懂的人在討論可不可能盜用ChatGPT,70F 01/30 08:26

→ : 都是以完全蒸餾的前提,這前提就錯了,有盜用的話,

→ : 可能只有部分用到gpt的生成,例如起頭或收尾

→ : 都是以完全蒸餾的前提,這前提就錯了,有盜用的話,

→ : 可能只有部分用到gpt的生成,例如起頭或收尾

推 : 你自己說更多企業能夠自行建置自家的AI 又說硬體73F 01/30 08:29

→ : 需求會減少? 供三小

因為算力需求等級不同啊 小模型專精領域+RL不需要那麼多硬體→ : 需求會減少? 供三小

那個是等比級數的差異

推 : 台灣很多人沒在思考的75F 01/30 08:29

推 : 推,進步的人去學習理解,而不是降階成意識政治戰76F 01/30 08:30

→ : 爭

→ : 爭

推 : 幫推 程式碼都開源了 不嘗試去驗證它 找投資機會78F 01/30 08:31

→ : 整天在那邊中國一定是假的 這樣會賺錢嗎

→ : 整天在那邊中國一定是假的 這樣會賺錢嗎

推 : 因為台灣就只剩下意識形態了80F 01/30 08:33

→ : R1應該是MoE版的V3,並不是V3 distallation81F 01/30 08:34

→ : 但V3其實一堆開源都做得到了 V3非常不怎樣82F 01/30 08:35

→ : 在這種算法開放的環境裡,算法重要厲害但不值錢,83F 01/30 08:36

→ : 除非你直接屌打,搶走所有市佔,因為大家都高手,幾

→ : 個禮拜內就能把你算法抄走了,倒頭來拼最強還是要

→ : 拼算力

→ : 除非你直接屌打,搶走所有市佔,因為大家都高手,幾

→ : 個禮拜內就能把你算法抄走了,倒頭來拼最強還是要

→ : 拼算力

推 : 這又不衝突 算力需求的減少 導致大公司不需要再買87F 01/30 08:36

→ : 那麼多晶片 但成本下降也讓中小公司可以進入 一個

→ : 加項 一個減項 誰比較多就看判斷 我跟原po都是認為

→ : 減項更大點 但不是一個因素永遠只會影響一個方向好

→ : 嗎 思考別太狹窄

因為不是每間公司都需要超高算力去瞬間得到結果→ : 那麼多晶片 但成本下降也讓中小公司可以進入 一個

→ : 加項 一個減項 誰比較多就看判斷 我跟原po都是認為

→ : 減項更大點 但不是一個因素永遠只會影響一個方向好

→ : 嗎 思考別太狹窄

小模型的service provider會蓬勃成長是真的

→ : 程式碼沒有開源啊,有的話連結給一下92F 01/30 08:37

→ : 只有model和inference的放出來

→ : 只有model和inference的放出來

→ : 還有資料94F 01/30 08:37

推 : 能幫助我的工作就是好工具95F 01/30 08:38

推 : 還好還有正常人 但你講這麼多 井蛙還是只會呱呱96F 01/30 08:41

推 : github有人在試著重建阿d大可以去幫忙97F 01/30 08:41

→ : 那就不是他開源啊,你在講啥?98F 01/30 08:42

多數討論是V3是GPT distillation而不是R1吧,但V3是什麼大家關注的焦點嗎?XDDD推 : Hugging face已經宣佈要復現DeepSeek了 急啥99F 01/30 08:42

→ : 程式碼開源=有程式碼可以檢視他怎麼做的100F 01/30 08:44

→ : 上面只有model和inference的code

→ : 還有一些paper解釋他的想法

→ : 用來復現的repo連結可以給一下嗎?

→ : 上面只有model和inference的code

→ : 還有一些paper解釋他的想法

→ : 用來復現的repo連結可以給一下嗎?

推 : 講開源的又不是我== 難怪老馬要告openai104F 01/30 08:46

→ : 上面推文自己找 不然你可以問ai阿

→ : 上面推文自己找 不然你可以問ai阿

推 : 推個106F 01/30 08:47

推 : 股板拼的是真金白銀真的沒必要在那邊搞意識形態,108F 01/30 08:48

→ : 真金白銀不會騙人也是這個世界的準則之一,意識形

→ : 態大部分都是各方利益角逐之下的產物

→ : 真金白銀不會騙人也是這個世界的準則之一,意識形

→ : 態大部分都是各方利益角逐之下的產物

→ : 上面沒有任何一個推文有復現或是開源的連結啊111F 01/30 08:48

推 : 整天講開源,結果什麼也沒給112F 01/30 08:51

推 : 我不是貼了嗎?113F 01/30 08:51

→ : https://i.imgur.com/yzWlOPx.jpeg

→ : 你是來惡搞的吧

→ : https://i.imgur.com/bjceGSQ.jpeg

→ : https://i.imgur.com/yzWlOPx.jpeg

→ : 你是來惡搞的吧

→ : https://i.imgur.com/bjceGSQ.jpeg

![[圖]](https://i.imgur.com/yzWlOPxh.jpeg)

![[圖]](https://i.imgur.com/bjceGSQh.jpeg)

開源應該是官方直接打包丟出來

推 : 一堆鄉民只會搞意識形態117F 01/30 08:55

推 : 青鳥和民進黨不喜歡這篇文章118F 01/30 08:56

噓 : 最好笑的是那些吹前麵線部長的,真的丟人現眼119F 01/30 08:57

推 : 對啊 demin不是要問復現的連結嗎120F 01/30 08:58

他是要官方自行放出的開源,這種復刻確實不算是開源啦但Method有公開其實算不錯了

推 : 剛好這事件可以讓人更看清,台灣媒體的本質水準有多121F 01/30 09:01

→ : 低劣

→ : 低劣

推 : 這個就是在專業領域方面有優勢123F 01/30 09:01

推 : 既然人力物力不多 台灣應該討論的是趕快跟上124F 01/30 09:02

→ : 用不多

沒錯,其實我想表達的在這邊→ : 用不多

結果大家居然在討論不能問"台灣"問"64",或會不會被中國盜帳號.....有點可笑

→ : 這種模型訓練project 不太可能完全開源,完全開源連126F 01/30 09:02

→ : 資料都要丟給大家耶

→ : 資料都要丟給大家耶

→ : 很適合企業針對自身專業佈建AI環境128F 01/30 09:03

推 : 反正扯到中國有人就會失智129F 01/30 09:03

推 : 跟台灣媒體沒有一定的關係 台灣媒體的做法是完全接130F 01/30 09:03

→ : 受美西方媒體的說法 然後刪除對中國或中國產業有利

→ : 的部分 放大對中國或中國產業不利的部分

我以為PTT都是受過教育的,結果像某W開頭的56一直扯一堆有的沒有的真的不行→ : 受美西方媒體的說法 然後刪除對中國或中國產業有利

→ : 的部分 放大對中國或中國產業不利的部分

→ : 用他們的做法可以做出差不多的高效率就是不錯的驗133F 01/30 09:03

→ : 證了

→ : 證了

→ : 還有人看短期股價就知道了 笑死 難道不知道市場會被135F 01/30 09:04

→ : 乳魔影響 錯誤定價

→ : 乳魔影響 錯誤定價

→ : 這個很正常 因為中美兩大勢力在激烈競爭 你在中國媒137F 01/30 09:04

→ : 體也常常看到贏麻了 西方慌了之類的小粉紅言論

→ : 網路時代 每個人都需要對事件核心瞭解的更透徹 才

→ : 能避免被媒體這些工具主導你的行為

→ : 體也常常看到贏麻了 西方慌了之類的小粉紅言論

→ : 網路時代 每個人都需要對事件核心瞭解的更透徹 才

→ : 能避免被媒體這些工具主導你的行為

→ : 剛剛在看上面的連結,原始的dataset是R1自身,看可以141F 01/30 09:06

→ : 透過distill的方法怎麼提升

→ : 透過distill的方法怎麼提升

推 : 「我以為PTT都是受過教育的」您誤會大了吧143F 01/30 09:09

推 : DS會讓AI應用公司門檻大幅降低144F 01/30 09:09

推 : 我在ChatGPT問愛坡斯坦蘿莉島也會被和諧啊 問以色列145F 01/30 09:10

→ : 是否在加薩種族屠殺人口滅絕他也會政治正確啊

→ : 不能在DS問64跟習近平很合理啊

→ : 是否在加薩種族屠殺人口滅絕他也會政治正確啊

→ : 不能在DS問64跟習近平很合理啊

推 : 股版比較就事論事,別去政黑版看就好,反正不管怎麼148F 01/30 09:11

→ : 發展TSM買下去

→ : 發展TSM買下去

推 : ChatGPT會用邏輯自洽來為以色列在加薩屠殺取得正當150F 01/30 09:12

→ : 性,DS是直接不回答 但兩者本質都是言論審查只是形

→ : 式不一樣而已

→ : 性,DS是直接不回答 但兩者本質都是言論審查只是形

→ : 式不一樣而已

推 : 台灣政府控制的媒體就是不能客觀報導中國公司的優點153F 01/30 09:16

→ : 啊

→ : 啊

→ : 台灣綠色網紅媒體拼命帶風向155F 01/30 09:17

推 : 扯到超導體的人 認為Ai都是騙局。他們才會混為一談156F 01/30 09:18

→ : 啦。笑爛

→ : 啦。笑爛

推 : 推你這篇158F 01/30 09:22

推 : 政黑網軍出蟑螂窩不是都出來洗地的嗎?呵呵159F 01/30 09:24

推 : 推 推160F 01/30 09:25

推 : 沒辦法,台灣有太多人聽到中國就會自動降智,這些人161F 01/30 09:27

→ : 應該不太適合投資

→ : 應該不太適合投資

推 : 要這些網紅名嘴看論文太難了163F 01/30 09:27

→ : 當初看高虹安的論文倒是大家都變電腦高手 笑死人哈

→ : 哈哈哈哈哈

→ : 當初看高虹安的論文倒是大家都變電腦高手 笑死人哈

→ : 哈哈哈哈哈

推 : 學習到了166F 01/30 09:29

噓 : 這是中國自主研發的167F 01/30 09:30

推 : 這樣meta之後還敢開源模型嗎168F 01/30 09:31

→ : 不用看論文阿 你去reddit專版裡面討論風氣都很好169F 01/30 09:34

→ : 尤其是技術性的東西 裡面很多解釋都很中立而且很清

→ : 楚

→ : 尤其是技術性的東西 裡面很多解釋都很中立而且很清

→ : 楚

推 : 存172F 01/30 09:37

推 : 你是中吹?買A股了嗎?173F 01/30 09:38

→ : 台灣這次真的蠻誇張的,論文跟開源都出來了結果講174F 01/30 09:39

→ : 技術的沒幾個,一堆阿貓阿狗開吹開嘴

→ : 技術的沒幾個,一堆阿貓阿狗開吹開嘴

推 : 因為懂技術的沒多少人 扯政治比較有收視率176F 01/30 09:40

噓 : 中國製造,先打問號177F 01/30 09:41

噓 : 最後只會大模型吞小模型 軍備競賽依然持續178F 01/30 09:44

邊際成本問題 太多人不了解CAPEX支出模型了※ 編輯: zzahoward (1.163.78.138 臺灣), 01/30/2025 09:46:21

噓 : Reddit一致好評那是因為你跑去中國人創的community179F 01/30 09:45

→ : ,我在歐洲還沒聽過有人說deepseek好用,你乾脆去看

→ : askchinese不是比較快

→ : ,我在歐洲還沒聽過有人說deepseek好用,你乾脆去看

→ : askchinese不是比較快

→ : 歐洲AI的發展...?182F 01/30 09:47

→ : 歐洲...XD183F 01/30 09:48

推 : 玩技術的還想要跨過中國產出的資訊我只能說你很勇184F 01/30 09:49

→ : 便宜是便宜,但效能就是只針對特定資料集測,實驗室185F 01/30 09:49

→ : 內時速180,實驗室外直接翻車,這個就是中共release

→ : 出來騙數據的,已經report會用個人資料外漏風險

→ : 內時速180,實驗室外直接翻車,這個就是中共release

→ : 出來騙數據的,已經report會用個人資料外漏風險

推 : 我體感用起來怎麼是R1比較囉嗦,但我喜歡它完整分享188F 01/30 09:49

→ : 推理過程

→ : 推理過程

推 : 難得看到股版有水準的文章,一堆不是搞ai 的人在那190F 01/30 09:50

→ : 邊亂扯就無言

→ : 邊亂扯就無言

→ : 你去看reddit就是歐洲,美國也該去看X192F 01/30 09:50

→ : 主要是要看他的primary model 怎麼來的 它更像加193F 01/30 09:53

→ : 個前置後置 先對prompt處理 再丟到基礎模型 產

→ : 出後再處理一遍 這個外加模型成本自然小 重點是

→ : 基礎模型產生的過程

→ : 個前置後置 先對prompt處理 再丟到基礎模型 產

→ : 出後再處理一遍 這個外加模型成本自然小 重點是

→ : 基礎模型產生的過程

推 : 在台灣只要會操作意識型態就可以賺錢了197F 01/30 09:54

→ : 怕資料被中國看就下載小版本本地run啊198F 01/30 09:54

→ : Project digits才3000塊耶

→ : Project digits才3000塊耶

→ : gpt4是不如它 got現在要拿o1跟它比才能壓制200F 01/30 09:57

噓 : 所以咧?? 不就一樣的東西201F 01/30 10:03

推 : 党還是覺得點麵線比較強 党的信徒深信不疑202F 01/30 10:10

推 : 青鳥:沒有台灣價值CC203F 01/30 10:10

推 : 推推204F 01/30 10:14

推 : 青鳥表示 肯定中國就是中共代理人205F 01/30 10:16

→ : 自己人沒事兒206F 01/30 10:20

推 : 推207F 01/30 10:25

→ : 現實就是查公司內部資料庫的AI不用回答摩鐵怎麼訂(208F 01/30 10:26

→ : 還是其實有需要?)

→ : 還是其實有需要?)

噓 : 這消息早就不是新東西了 llm剛出來的時候就一堆碼210F 01/30 10:27

→ : 農在分析生成方式 只有87台灣人還在自己的小圈圈自

→ : 嗨

→ : 農在分析生成方式 只有87台灣人還在自己的小圈圈自

→ : 嗨

推 : 推213F 01/30 10:28

推 : 推214F 01/30 10:29

推 : 推這篇215F 01/30 10:30

推 : 推216F 01/30 10:32

推 : 推217F 01/30 10:33

推 : 推 但是文組青鳥會視而不見218F 01/30 10:42

推 : 誰還在講歐洲llm的發展,都已經拿法規砸爛所有llm219F 01/30 10:43

→ : 了,何來的發展,笑死

→ : 了,何來的發展,笑死

推 : 理性思考221F 01/30 10:48

推 : 推一個,真心建議政治廚別再影響台灣學術界了222F 01/30 10:48

→ : 我反而覺得AI股價不準,因為想上車的人太多了,搞下223F 01/30 10:50

→ : 來才好進場

→ : 來才好進場

推 : 瞎扯是牠們的工作,不過「我以為PTT都是受過教育的225F 01/30 10:54

→ : 」,這個真的是天大的誤會 XDDD

→ : 」,這個真的是天大的誤會 XDDD

→ : 畢竟政府忙著花你稅金造謠啊227F 01/30 10:54

→ : 意識形態是可以選擇性降低智商的 @@a228F 01/30 10:55

推 : 政確不需要智商 我唐鳳世界第一229F 01/30 11:19

推 : 推個230F 01/30 11:25

推 : 推231F 01/30 11:25

推 : 推清醒的人232F 01/30 11:37

推 : 那些說去看reddit的是看哪版 我目前在幾個AI相關233F 01/30 11:39

推 : 看來至少Openai被破解了234F 01/30 11:39

→ : 都是對DS的言論審查反感 但讚賞它的開源,對於OpenAI235F 01/30 11:40

→ : 大多都是在酸Y

→ : 大多都是在酸Y

推 : 人家開源技術回饋給全世界 卻用意識形態看有點可惜237F 01/30 11:42

推 : 居然有學生說沒有原始程式碼不是開源238F 01/30 11:52

→ : 服了 幾百萬鎂的案子還要把原始碼交出來嗎

→ : 服了 幾百萬鎂的案子還要把原始碼交出來嗎

推 : 我是不知道為啥一票台灣人把OpenAI當神拜240F 01/30 11:53

→ : 他們是很大沒錯啦 但在這個領域爭議也是很多捏

→ : 他們是很大沒錯啦 但在這個領域爭議也是很多捏

→ : 沒有要交出來,而是你不開放程式碼不叫做開源啊242F 01/30 11:55

→ : 人家根本沒有開源碼,一堆人不懂還幫亂吹

→ : 人家根本沒有開源碼,一堆人不懂還幫亂吹

推 : 推244F 01/30 12:12

推 : 藍白粉自己先造謠一條龍又怪青鳥網軍上車喔??邏輯245F 01/30 12:20

→ : ?

→ : ?

噓 : 一堆中吹借題發揮貶低台灣跟美國啊247F 01/30 12:25

推 : 有推文頗呵 笑死248F 01/30 12:27

推 : 專業推 尤其又有圖表 看的真舒服249F 01/30 12:31

推 : 臺灣這幾天真的好多無用的資訊 帶意識形態瞎吹硬貶250F 01/30 12:32

→ : 的太多了 想找專業的還是看國外的文章吧

→ : 的太多了 想找專業的還是看國外的文章吧

推 : 推你專業訓練鄉民理解252F 01/30 12:33

→ : 想賺錢就別帶什麼意識形態253F 01/30 12:35

推 : 現在inference還要一定成本 更別說training資源不是254F 01/30 12:37

推 : 某板都說這裡吹DS已經被藍白佔領了255F 01/30 12:37

→ : 幾張家用顯卡就能負擔 只是讓LLM調教門檻下放到一般256F 01/30 12:37

→ : 企業 硬體需求依然在而且變大家都能參與甚至會更缺

→ : 企業 硬體需求依然在而且變大家都能參與甚至會更缺

推 : 推推258F 01/30 12:44

→ : 人家只是千萬別抬頭 党這邊可是連燈都不要開259F 01/30 12:45

→ : 程式本來就這樣,只要在合理的範圍使用,沒有人會重260F 01/30 12:46

→ : 新去造輪子,善用現有的資源才對

→ : 新去造輪子,善用現有的資源才對

推 : 就DS的各種想法 以前很多討論都有出現過262F 01/30 12:48

→ : 像是大模型=>中模型=>小模型 範圍越小精度越高

→ : 如何用自動標記取代人類標記 則是更久遠之前的議題

→ : 這次該訝異的是 為何會被中國人先推出

→ : 這對那些大廠中的專業資工人絕對是很自然而然的想法

→ : 像是大模型=>中模型=>小模型 範圍越小精度越高

→ : 如何用自動標記取代人類標記 則是更久遠之前的議題

→ : 這次該訝異的是 為何會被中國人先推出

→ : 這對那些大廠中的專業資工人絕對是很自然而然的想法

推 : 我這幾天看deepseek時,也是一直在思考它的技術跟它267F 01/30 12:56

→ : 的成果,以及針對一些技術問題過程,它的思維,讓我

→ : 很讚嘆,結果看到新聞跟聊天一堆人在問64、天安門,

→ : 我是蠻傻眼的...問那些跟你的日常跟工作有關嗎

推 : 我偶爾需要跟中國人去溝通,因為公司有 中、越、印

→ : ,以前也會看B站的影片,所以知道,你不要去觸碰到

→ : 那些有的沒的,單純談工作跟正事就好了,故意要去碰

→ : 人家逆麟,你怎麼不去美國喊3K、跟黑人說尼哥

→ : 每個地方都有自己禁忌的東西,尊重就好,技術本身就

→ : 只是技術,而且還開源,就可以驗證。

→ : 的成果,以及針對一些技術問題過程,它的思維,讓我

→ : 很讚嘆,結果看到新聞跟聊天一堆人在問64、天安門,

→ : 我是蠻傻眼的...問那些跟你的日常跟工作有關嗎

推 : 我偶爾需要跟中國人去溝通,因為公司有 中、越、印

→ : ,以前也會看B站的影片,所以知道,你不要去觸碰到

→ : 那些有的沒的,單純談工作跟正事就好了,故意要去碰

→ : 人家逆麟,你怎麼不去美國喊3K、跟黑人說尼哥

→ : 每個地方都有自己禁忌的東西,尊重就好,技術本身就

→ : 只是技術,而且還開源,就可以驗證。

推 : 所以樓上到底在供三小,先紮稻草人喔277F 01/30 13:08

推 : 有一說一 deepseek手機版式的審查是真的誇張啊278F 01/30 13:12

推 : 現在看到一個比較有意義的擔憂是成本降低要小心279F 01/30 13:13

→ : AI落到犯罪組織手裡會不會帶來什麼風險

→ : 不過感覺時間線放長這也不太可避

→ : AI落到犯罪組織手裡會不會帶來什麼風險

→ : 不過感覺時間線放長這也不太可避

推 : 推282F 01/30 13:17

→ : 當你拿真金白銀來進場 選擇未來佈局 什麼意識形態283F 01/30 13:23

→ : 都是假的 看清局勢才能進退自如

→ : 都是假的 看清局勢才能進退自如

推 : GRPO根本不是這篇吧==285F 01/30 13:26

推 : 你這樣深深傷了台灣某些玻璃的心286F 01/30 13:27

→ : 台灣就這樣,不少人三不五時用政治眼光來討論287F 01/30 13:30

→ : GRPO是Group Relative Policy Optimization288F 01/30 13:30

推 : 把問題拆成小步驟並找出一個可行解真的厲害289F 01/30 13:47

推 : 錢才是公平的290F 01/30 13:55

噓 : 因為最一開始吹的就是在吹中國啊291F 01/30 14:26

推 : 用心給推292F 01/30 14:29

→ : 脆鳥會說你不懂293F 01/30 15:11

推 : 我的言論算起來是扎稻草人嗎? 如果是的話,那當我沒294F 01/30 15:14

→ : 說好了,因為我是根據這幾天看到的輿論,得到的感想

推 : https://chatgpt.com/share/679b2756-031c-8013-

→ : a164-bf146842cc23 去問了一下chat gpt,看來我後面

→ : 拿3k跟n-word比喻有失當

→ : 說好了,因為我是根據這幾天看到的輿論,得到的感想

推 : https://chatgpt.com/share/679b2756-031c-8013-

→ : a164-bf146842cc23 去問了一下chat gpt,看來我後面

→ : 拿3k跟n-word比喻有失當

推 : 這篇正解 網軍國家隊這幾天真的很急299F 01/30 17:16

推 : 脆鳥:有比我們添財少女懂嗎?300F 01/30 17:17

推 : 因為是中國研發的,如果是米國的就沒這些問題301F 01/30 18:30

推 : 認真推302F 01/30 19:00

推 : 推303F 01/30 19:11

--

※ 看板: Stock 文章推薦值: 1 目前人氣: 0 累積人氣: 804

作者 zzahoward 的最新發文:

- 44F 12推 2噓

- 我不太能理解為什麼大家都說epower是很棒的技術? epower這東西,基本上都市小車通勤還可以,你碰到動力需求高一點的情況 這套系統根本就是死路 所以為什麼之前北美不上? Infiniti也不上 …97F 43推

- 標題有點亂下,我們來看看原文是怎麼說 以上是CNBC的報導,至於CNBC跟LTN誰比較有公信力就見仁見智了 DeepSeek’s AI model “is probably the best wor …82F 39推 6噓

- 今天我看Trump的直播 It will apply to all countries, "without exceptions" 這篇新聞也有提到 所以一些人說台灣會被排除在鋼鐵 …45F 24推 2噓

點此顯示更多發文記錄

( ̄︶ ̄)b ccZ8Z8Z8 說讚!

→

guest

回列表(←)

分享